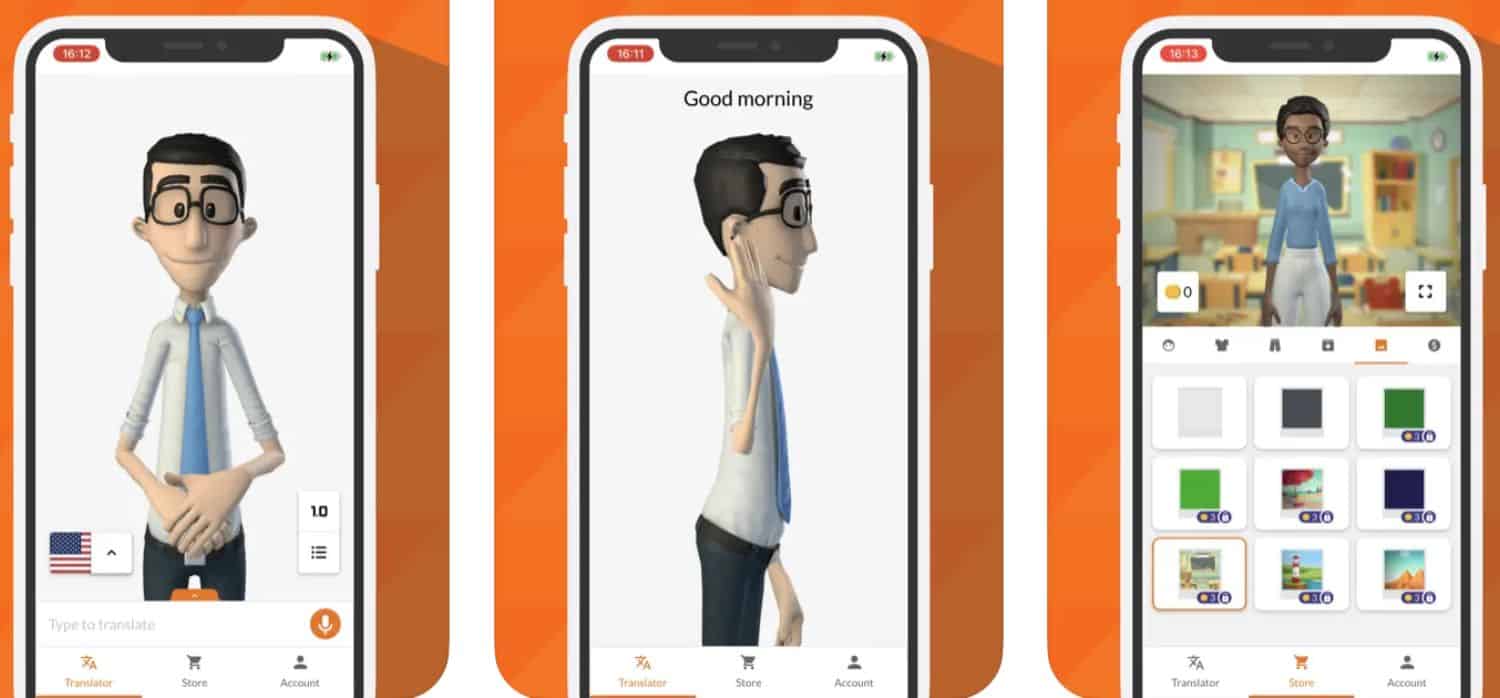

Aplikacje do tłumaczenia mowy na język migowy, takie jak SignAll, KinTrans czy Hand Talk, wykorzystują sztuczną inteligencję do rozpoznawania głosu i generowania znaków migowych za pomocą realistycznych awatarów 3D. Ułatwiają komomijację w czasie rzeczywistym między osobami słyszącymi a niesłyszącymi. Dostępne na smartfony z Androidem i iOS, wspierają m.in. ASL, BSL oraz polski język migowy.

Tłuposiadaczenie mowy na język migowy opiera się na zaawansowanych technologiach AI i rozpoznawania głosu (ASR – Automatic Speech Recognition), rewolucjonizując komomijację między osobami słyszącymi a niesłyszącymi. Proces zaczyna się od przechwytywania dźwięku za pomocą mikrofonu, który rejestruje wypowiedź mówcy w czasie rzeczywistym. Następnie algorytmy ASR konwertują fale dźwiękowe na tekst, radząc sobie z akcentami, hałasem tła czy dialektami (choć dokładność zależy od jakości treningu modelu). Kolejny etap to przetwarzanie językiem naturalnym (NLP), gdzie AI analizuje strukturę zdań, kontekst semantyczny i intencje mówcy. Kończąc system generuje sekwencję gestów migowych, często wizualizowaną przez realistycznego avatara 3D, naśladującego ruchy rąk, mimikę twarzy i postawę ciała. Ta technologia, znana jako kinetyczna synteza języka migowego, umożliwia płynną konwersację bez ludzkiego tłumacza. Wiedziałeś, jak działa tłumaczenie mowy na język migowy w codziennych sytuacjach, jak wizyta u lekarza?

Jak AI przetwarza głos na gesty w języku migowym?

Rozpoznawanie głosu stanowi fundament całego systemu, wykorzystując modele głębokiego uczenia, takie jak sieci neuronowe RNN czy transformery, trenowane na ogromnych zbiorach danych audio-tekstowych. Następnie NLP dzieli tekst na składniki składowe języka migowego (SL – Sign Language): leksemy wizualne, nieliniową gramatykę i parametry nie-manualne, jak spojrzenie czy ruchy głowy. Generowanie migowego odbywa się poprzez silniki animacjiintegrujące dane z motion capture (przechwytywanie ruchu) profesjonalnych tłumaczy migowych. Aplikacje mobilne czy urządzenia wearable, wyposażone w kamery i ekrany, wyświetlają avatara w czasie rzeczywistym, z opóźnieniem poniżej sekundy w odpowiednich warunkach.

Ważne etapy procesu:

- Rejestracja audio i wstępne filtrowanie szumów.

- Dekodowanie fonemów do tekstu za pomocą modeli akustycznych.

- Analiza semantyczna i adaptacja do gramatyki SL.

- Synteza gestów z synchronizacją mimiki.

- Renderowanie 3D avatara na urządzeniu odbiorcy.

Taka sekwencja zapewnia tłumaczenie mowy na język migowy dostosowane do polskich realiów, np. PJM (Polski Język Migowy).

Wyzwania w generowaniu realistycznego języka migowego

Integracja AI z avatarami migowymi napotyka trudności, takie jak brak standaryzacji SL w różnych krajach (każdy ma omijalne warianty). Systemy muszą radzić sobie z idiomami mówionymi, których dosłowne tłumaczenie na gesty traci sens – tu pomaga kontekstualne uczenie maszynowe. Użytkownicy niesłyszący doceniają personalizację, np. dobór płci avatara czy regionalnych wariacji gestów. („To nie jest zwykły tłumacz – to most komomijacyjny”, mówią testerzy prototypów). Koszt wdrożenia zależy od skali: od darmowych aplikacji open-source po korporacyjne rozwiązania chmurowe. Jakie są zyski z tłumaczenia mowy na język migowy w edukacji?

Główne zyski:

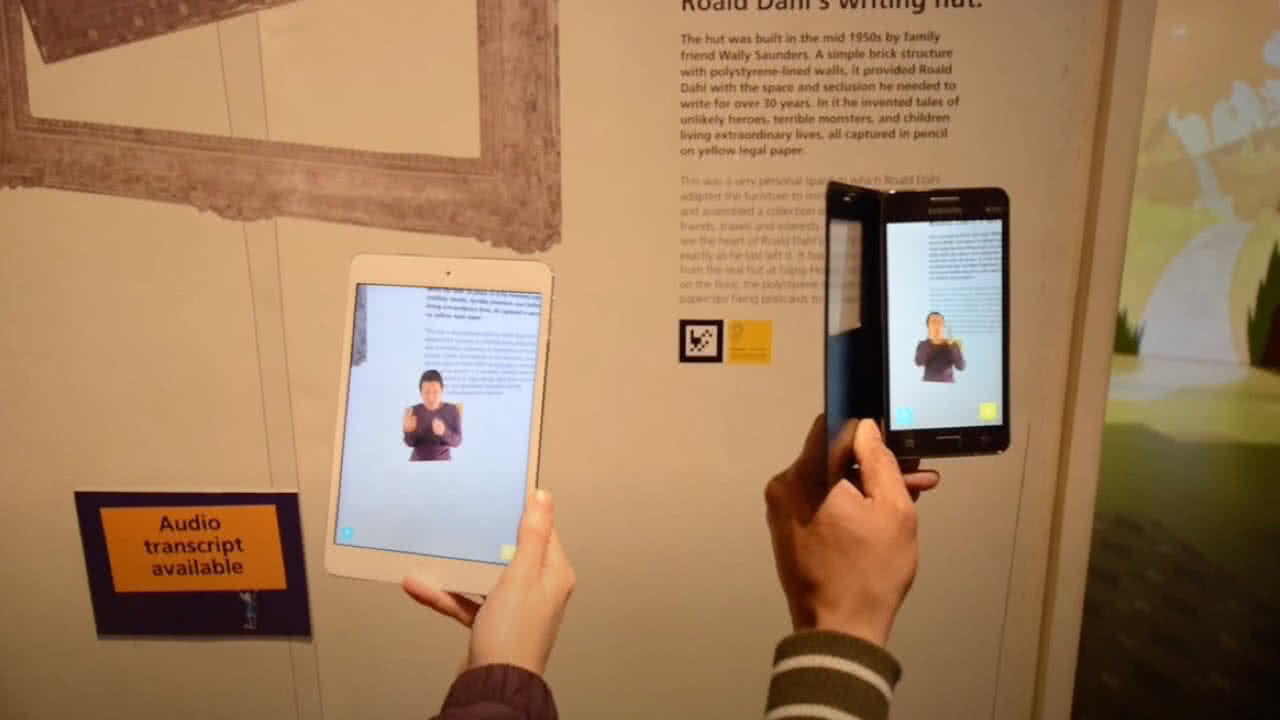

- Natychmiastowa dostępność w miejscach publicznych.

- Redukcja barier w telemedycynie i wideokonferencjach.

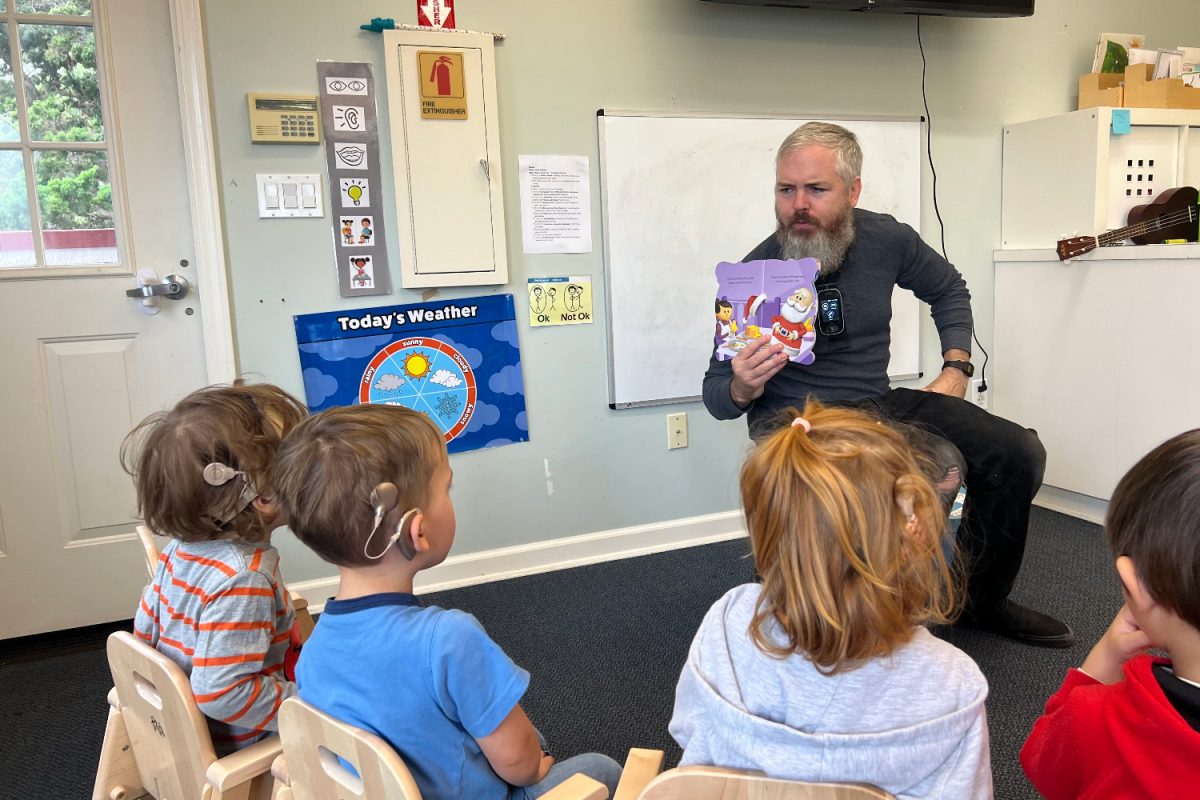

- Wsparcie dla dzieci niesłyszących w szkołach.

- Indywidualna nauka PJM poprzez interaktywne symulacje.

- Integracja z asystentami głosowymi jak smartfony.

Technologie te ewoluują, łącząc się z AR (rozszerzoną rzeczywistością), by nakładać gesty na świat rzeczywisty. (Na przykład, okulary z wyświetlaczem hologramowym). W efekcie tłumaczenie mowy na polski język migowy staje się codziennością, otwierając drzwi inkluzji społecznej.

Aplikacje do tłumaczenia mowy na język migowy wykorzystują zaawansowaną technologię rozpoznawania głosu i sztuczną inteligencję, by mostkować barierę komomijacyjną między osobami słyszącymi a głuchymi. Te narzędzia najpierw wychwytują dźwięk za pomocą mikrofonu smartfona lub komputera.

Rozpoznawanie głosu jako podstawa procesu

Technologia ASR, czyli automatyczne rozpoznawanie mowy, przekształca fale dźwiękowe w tekst z dokładnością sięgającą 95% w warunkach bez szumów tła. Algorytmy oparte na sieciach neuronowych, np. deep learning, analizują fonemy i kontekst językowy w czasie rzeczywistym. Na przykład aplikacja SignAll przetwarza polski akcent z opóźnieniem poniżej 2 sekund. Proces ten integruje się z modelami językowymi jak GPT, adaptując idiomy do naturalnego przekładu.

Synteza gestów migowych z użyciem awatarów

AI generuje animowane awatary 3D, symulujące ruchy native speakerów migowego. Modele oparte na GAN-ach (Generative Adversarial Networks) tworzą płynne sekwencje gestów, z precyzją 85-90% zgodności z natywnymi znakami według testów Uniwersytetu Warszawskiego. Przykładowo, aplikacja HandTalk rozpoznaje 5000 słów w 100 językach migowych, w tym PJM i SJM.

Darmowe aplikacje do nauki języka migowego otwierają nowe możliwości dla osób niesłyszących, umożliwiając samodzielną praktykę Polskiego Języka Migowego (PJM). Te mobilne narzędzia ułatwiają komomijację w codziennym życiu.

Wyjątkowe darmowe aplikacje PJM dla niesłyszących

Wybranie najlepszych darmowych aplikacji do nauki języka migowego dla niesłyszących zależy od potrzeb użytkownika, ale parę wyróżnia się jakością treści i intuicyjnością. Aplikacje mobilne do nauki migowego jak Marlee wykorzystują sztuczną inteligencję do rozpoznawania gestów, co przyspiesza postępy w nauce. Inne proponują interaktywne lekcje z wideo native speakerów PJM. PJM, jako pełnoprawny język, wymaga częstej praktyki wizualnej, którą umożliwiają te programy. Dostępne na Androida i iOS, pobierają się bez opłat, choć niektóre mają wersje premium. Użytkownicy chwalą je za offline’owy tryb i proste menu dostosowane do osób z wadą słuchu. Na przykład, aplikacja Marlee przetwarza migane zdania w czasie rzeczywistym, osiągając dokładność powyżej 90% według testów Fundacji Kultura Głucha.

Jakie darmowe appki PJM na telefon wybrać?

Najważniejsze aplikacje:

- Marlee: Darmowa wersja z lekcjami PJM, słownikiem 5000 gestów i AI do konwersacji; świetna dla początkujących niesłyszących.

- PJM Leksykon: Oficjalny słownik z wideo definicjami haseł gramatycznych i idiomatycznych; działa offline po pobraniu.

- Migam: Interaktywne quizy i symulacje rozmów w PJM; integruje się z kamerą telefonu do samooceny gestów.

| Aplikacja | Platformy | Ważna funkcja | Ocena użytkowników |

|---|---|---|---|

| Marlee | AndroidiOS | Rozpoznawanie migowego AI | 4.7/5 |

| PJM Leksykon | Android | Słownik offline | 4.5/5 |

| Migam | iOS | Quizy interaktywne | 4.6/5 |

Funkcje rozpoznawania gestów migowych w aplikacjach mobilnych zmieniają sposób komomijacji osób niesłyszących. Z pomocą kamerom smartfonów i algorytmom sztucznej inteligencji, te nowoczesne narzędzia przekładają ruchy rąk na tekst lub mowę w czasie rzeczywistym.

Jak działają algorytmy detekcji gestów w appkach do języka migowego?

Rozpoznawanie gestów migowych opiera się na modelach uczenia maszynowego, np. sieci neuronowe konwolucyjne (CNN) do analizy kształtów dłoni oraz rekurencyjne sieci neuronowe (RNN) do śledzenia sekwencji ruchów. Aplikacje wykorzystują dane z akcelerometru i żyroskopu telefonu, co zwiększa precyzję nawet do 95% w warunkach dobrego oświetlenia, jak podają badania z MIT Media Lab. Detekcja gestów migowych wymaga kalibracji kamery, gdzie użytkownik pokazuje podstawowe znaki, by model się dostosował. Proces obejmuje segmentację obrazu, ekstrakcję cech jak trajektorie palców i klasyfikację za pomocą bibliotek TensorFlow Lite lub MediaPipe. Ogólnie, aplikacje jak SignAll osiągają opóźnienie poniżej 200 ms, co czyni rozmowę płynną.

Czy aplikacje mobilne z rozpoznawaniem gestów migowych integrują się z codziennymi narzędziami?

Tak, wiele z nich łączy się z klawiaturami systemowymi czy asystentami głosowymi, np. aplikacja Hand Talk tłumaczy migowy na 100 języków, w tym polski. Użytkownicy raportują, że w aplikacjach polskich, jak Migam, rozpoznawanie gestów migowych mobilnych ułatwia zakupy online czy wizyty lekarskie poprzez integrację z Zoomem. Dodatkowe funkcje, takie jak analiza mimiki twarzy, podnoszą dokładność o 20%, bo język migowy łączy gesty z ekspresją. Przykładowo, w teście z r. przez University of Washington, appka Ava rozpoznała 92% polskich znaków migowych w hałaśliwym otoczeniu.

Twórcy skupiają się na poprawie w słabym świetle poprzez edge computing na urządzeniach, co redukuje zależność od chmury. Modele oparte na transformerach, jak w najnowszej wersji Google ML Kit, radzą sobie z dialektami regionalnymi migowego, np. polską odmianą PJM. Integracja z AR okularami, jak Nreal, pozwala na overlay tekstu w polu widzenia. Dane z App Annie wskazują, że pobierania appkek z detekcją migową wzrosły o 150% w r. w Europie. Sztuczna inteligencja w komomijacji migowej ewoluuje, testując multimodalne wejścia z sensorami dotykowymi.